티스토리 뷰

빅데이터 인공지능/딥러닝

[딥러닝] CNN 모델 소개(LeNet, AlexNet, VGG, GoogLeNet, ResNet, DenseNet)

doeunnkimm 2022. 11. 28. 18:53

▶ CNN 모델 소개(LeNet, AlexNet, VGG, GoogLeNet, ResNet, DenseNet)

1. ImageNet Dataset

우선 ImageNet 데이터 세트는 컴퓨터 비전 알고리즘들을 개발하기 위해 학계에서 설계한 인간 주석 사진의 매우 큰 모음입니다.

즉, 학계에서 모델의 성능을 평가할 때 자주 사용되는 데이터 세트로 이해하면 되겠습니다.

해가 거듭되면서 기술적으로 업그레이드 된 CNN 모델들을 살펴보면 아래와 같습니다.

12년도에 AlexNet이라는 모델이 처음 CNN을 모델을 대표해서 나왔는데요.

해를 거듭할수록 CNN 네트워크의 layer가 깊어지면서 error rate도 낮아지는 것을 확인할 수 있습니다.

2. LeNet

- Convolution Neural Network라는 개념을 최초로 개발한 Yann LeCun이 개발한 구조

- Conv Layer와 Pooling layer 2개, FC layer 3개로 총 5개의 레이어로 구성

- Tanh activation function을 활용

3. AlexNet

- AlexNet의 기본구조는 LeNet과 크게 다르지 않음

- 2개의 CPU로 병렬연산을 수행하기 위해 병렬적인 구조로 설계되었다는 점이 가장 큰 변화

- Conv Layer와 Pooling Layer 5개, FC layer 3개로 총 8개의 레이어로 구성

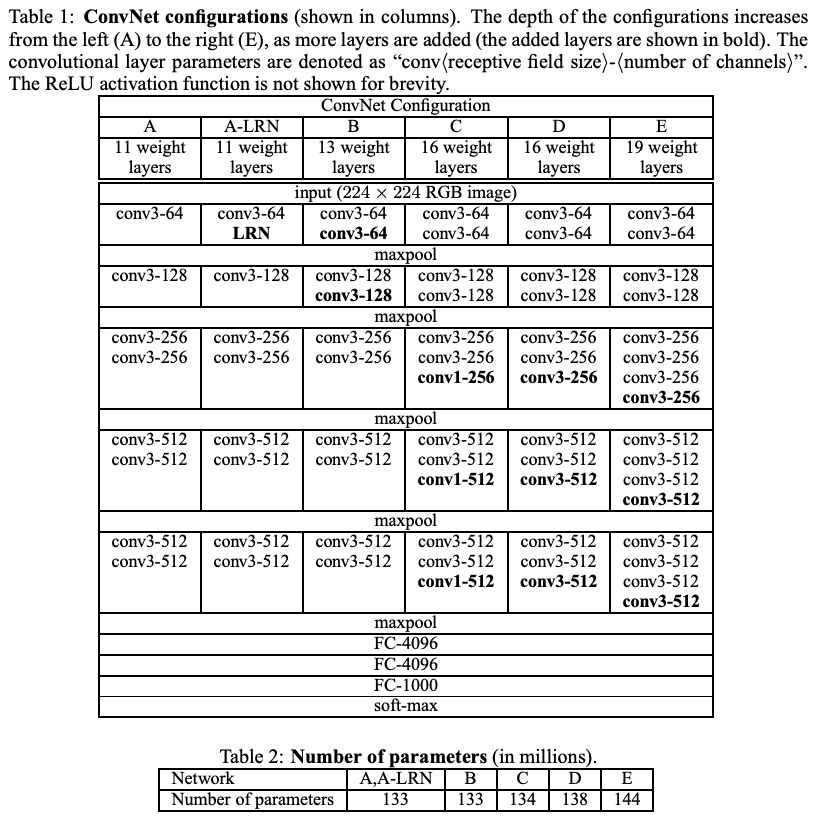

4. VGG(Visual Geometry Group)

- 옥스포트 대학의 연구팀 VGG에 의해 개발된 모델

- VGGNet은 16개 또는 19개의 레이어로 구성된 모델을 의미(VGG16, VGG19)

- 컨볼루션 필터 커널의 사이즈를 가장 작은 3x3으로 고정

- 커널 사이즈를 작게 함으로써 이미지의 사이즈를 천천히 축소

- 이로인해 네트워크의 깊이를 충분히 깊게 만듦

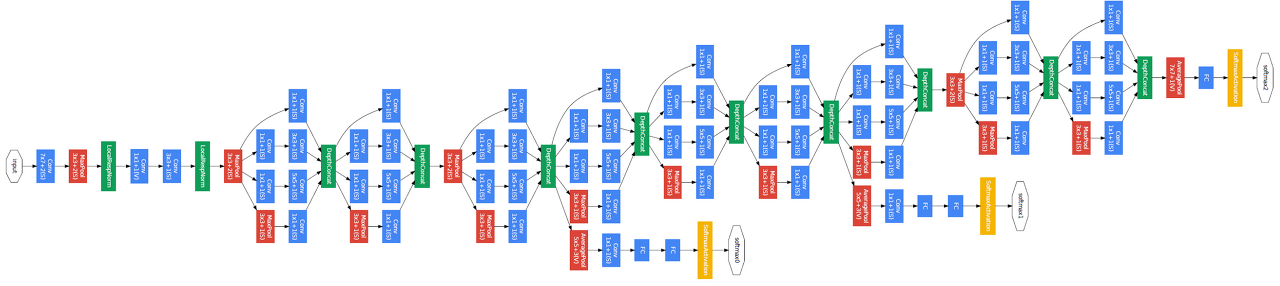

5. GoogLeNet

- GoogLeNet은 19층의 VGG19보다 좀 더 깊은 22층으로 구성

- Inception Module

- 아래 이미지에서 새로운 형태의 구조들을 발견 가능 ← Inception Module

- 컨볼루션을 활용할 때 이전 layer(1x1 컨볼루션, 3x3 컨볼루션, 5x5 컨볼루션 결과)를 모두 함게 쌓음

- 다각도로 이미지를 바라보는 것

- 컨볼루션을 활용할 때 이전 layer(1x1 컨볼루션, 3x3 컨볼루션, 5x5 컨볼루션 결과)를 모두 함게 쌓음

- 아래 이미지에서 새로운 형태의 구조들을 발견 가능 ← Inception Module

728x90

+ layer가 깊어지면서 생기는 문제점 : Vanishing gradient problem

- layer가 깊어질 수록 weight를 업데이트 하게 되는 과정에서 gradient 자체가 매우 작아져서 학습이 제대로 이뤄지지 X

- 이러한 문제를 해결하기 위해 ResNet 등장

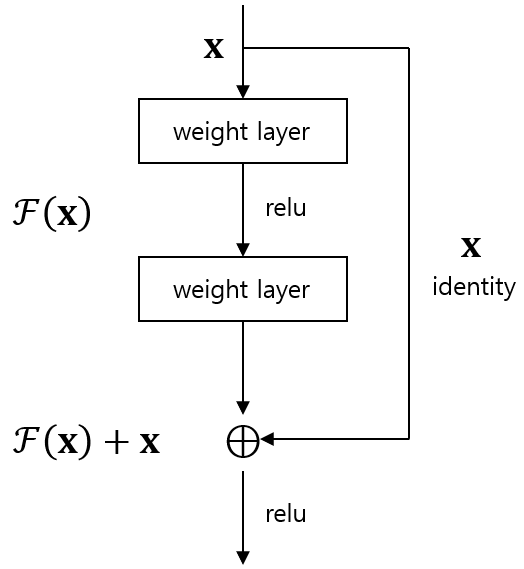

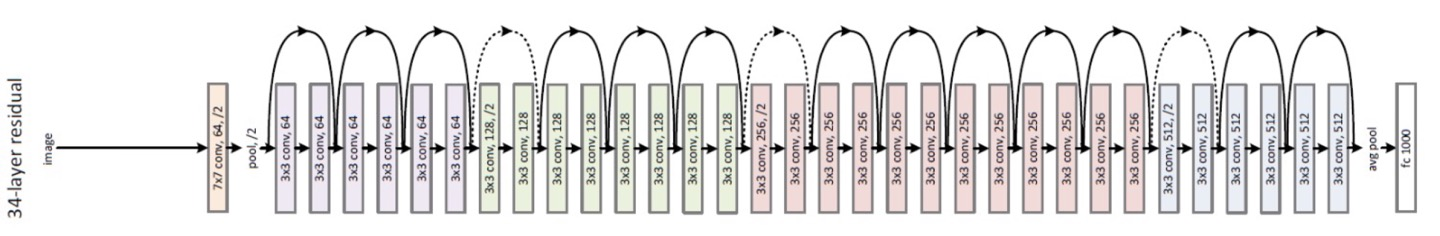

6. ResNet

- skip connection

- 중간 layer를 거치지 않는 x identity를 그래도 넘기는 line을 하나 연결

- x identity 값과 원래대로 layer를 거쳐서 나온 결과값을 더한 값을 학습( F(x) + x )

그래서 이게 어떻게 Vanishing Gradient Problem을 해결해주는데?

나온 결과값을 보게 되면 F(x)+x 입니다.

우리는 gradient를 계산할 때 미분을 하여 감소하는 방향으로 weight를 업데이트 했었는데요.

이때 ResNet의 block의 결과값 F(x)+x를 미분하더라도 F`(x)+1 형태가 되는데

두 번째 항의 +1 덕분에 깊은 layer까지도 gradient가 사라지는 문제가 발생하지 않도록 만들어주게 됩니다.

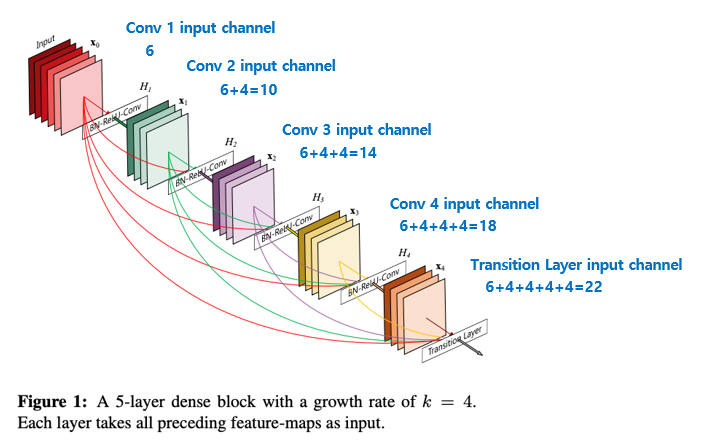

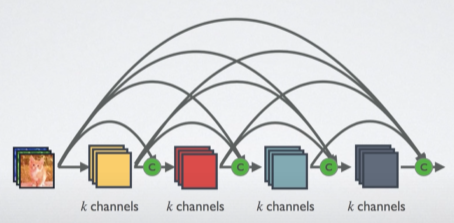

7. DenseNet

- Layer간의 정보가 흘러가는 것을 개선하기 위해, DenseNet에서는 ResNet과는 조금 다른 연결 패턴 제안

- 이전의 feature map들이 모든 후속 layer에 직접적으로 연결

728x90

LIST

'빅데이터 인공지능 > 딥러닝' 카테고리의 다른 글

| [딥러닝] RNN을 위한 PyTorch 구현 (1) | 2022.11.30 |

|---|---|

| [딥러닝] RNN(Recurrent Neural Network) (1) | 2022.11.30 |

| [딥러닝] CNN을 위한 PyTorch 구현 (0) | 2022.11.28 |

| [딥러닝] CNN(Convolutional Neural Network) A to Z (1) | 2022.11.26 |

| [딥러닝] MLP를 위한 PyTorch 구현 (0) | 2022.11.26 |

250x250

공지사항

최근에 올라온 글

최근에 달린 댓글

- Total

- Today

- Yesterday

링크

TAG

- 자바

- styled-components

- 프로젝트 회고

- 프론트엔드 공부

- 스타일 컴포넌트 styled-components

- 프론트엔드

- 자바스크립트

- 리액트 훅

- frontend

- HTML

- Python

- 머신러닝

- 프론트엔드 기초

- 리액트

- 딥러닝

- react

- jest

- 파이썬

- 인프런

- 데이터분석

- 타입스크립트

- next.js

- rtl

- 자바스크립트 기초

- TypeScript

- react-query

- testing

- 디프만

- JSP

- CSS

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | ||||

| 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 11 | 12 | 13 | 14 | 15 | 16 | 17 |

| 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| 25 | 26 | 27 | 28 | 29 | 30 | 31 |

글 보관함